1. 初期の生い立ちと教育

ティムニット・ゲブルはエチオピアのアディスアベバで育ち、エリトリア系の両親を持つ。

1.1. 出生と背景

ゲブルはエチオピアのアディスアベバで生まれた。彼女の両親は共にエリトリア出身である。電気工学の博士号を持つ父親は、彼女が5歳の時に亡くなり、経済学者である母親によって育てられた。

1.2. 移民とアメリカでの経験

ゲブルが15歳の時、エリトリア・エチオピア国境紛争中に家族の一部がエリトリアに送還され、戦争への徴兵を強制されたため、彼女はエチオピアを離れた。当初、アメリカ合衆国の査証を拒否され、一時的にアイルランドに居住したが、最終的にアメリカで政治亡命を認められた。彼女はこの経験を「悲惨だった」と述べている。

アメリカに渡ったゲブルはマサチューセッツ州サマービルで高校に通い、そこで直ちに人種差別を経験し始めたという。彼女は優秀な生徒であったにもかかわらず、一部の教師は特定のアドバンスト・プレイスメント(AP)コースの受講を認めなかった。高校卒業後、警察とのある出来事が、彼女をテクノロジー倫理に焦点を当てるきっかけとなった。彼女の友人である黒人女性がバーで暴行を受け、ゲブルが警察に通報したところ、暴行報告書を作成する代わりに友人が逮捕され、勾留された。ゲブルはこの出来事を「露骨な構造的な人種差別の例」であり、決定的な瞬間だったと語っている。

1.3. 学業とキャリアの始まり

2001年、ゲブルはスタンフォード大学に入学し、電気工学で学士号と修士号を取得した。2017年にはコンピュータービジョン分野で博士号を取得した。博士課程ではフェイフェイ・リ教授の指導を受けた。

博士課程在学中の2008年アメリカ合衆国大統領選挙では、バラク・オバマの支持を訴える戸別訪問活動を行った。2017年のLDVキャピタル・ビジョン・サミット・コンペティションで博士研究を発表し、優勝したことで、他の起業家や投資家との協業が始まった。また、2016年と2018年にはジェラニ・ネルソンが主催するプログラミングキャンペーン「AddisCoder」に参加するため、エチオピアに帰国している。

博士課程中に執筆されたものの未発表に終わった論文では、AIの未来に対する懸念を表明している。彼女は、AI分野における多様性の欠如の危険性について、自身の警察との経験や、ProPublicaによる予測的ポリシングに関する調査(機械学習における人間のバイアスの投影を明らかにしたもの)を中心に論じた。この論文では、AI分野の「ボーイズクラブ文化」を厳しく批判し、会議での男性参加者による性的嫌がらせの経験や、分野の著名人に対する英雄視を批判している。

2. キャリアと活動

ティムニット・ゲブルのキャリアは、AppleやMicrosoftでの初期のソフトウェア開発から、GoogleでのAI倫理研究、そして独立研究機関DAIRの設立に至るまで、AI技術の倫理的・社会的な影響に深く関わってきた。

2.1. 初期キャリア(Apple、Microsoft)

2004年から2013年まで、ゲブルはAppleにインターンとして入社し、ハードウェア部門でオーディオコンポーネント用の回路設計に従事した。翌年には正社員のオファーを受け、オーディオエンジニアとして勤務した。当時のマネージャーは彼女を「恐れを知らない」人物と評し、同僚からも慕われていた。Apple在籍中に、ゲブルはソフトウェア開発、特に人物を検出するコンピュータービジョンに関心を持つようになった。彼女は初代iPadの信号処理アルゴリズムの開発にも携わったが、当時はその技術が監視に利用される可能性については考えていなかったと述べている。

Apple退社後、2021年夏にAppleのエンジニアであるチェル・スカーレットが主導し、ゲブルも助言を与えたAppleToo運動において、彼女はAppleでの「多くの目に余る出来事」を経験したことを明かし、「彼らがどうやって世間の注目を浴びずに済ませているのか、いつも疑問に思っていた」と述べた。彼女はAppleにおける説明責任が長らく果たされてこなかったことを批判し、これ以上隠し通すことはできないだろうと警告した。また、メディアがAppleや他の巨大テクノロジー企業を報じる姿勢についても批判し、報道が企業を世間の監視から守る役割を果たしていると指摘した。

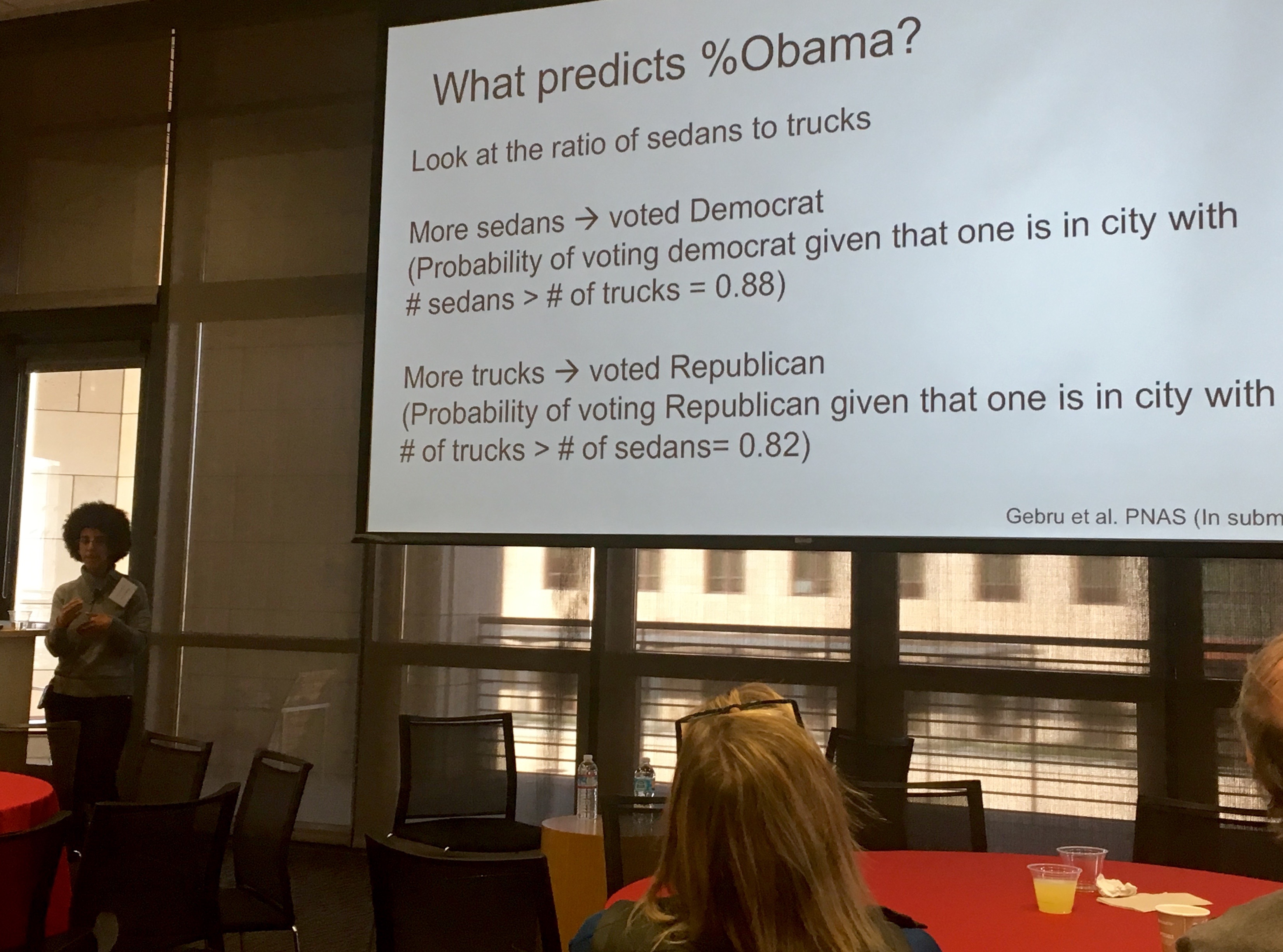

2013年、ゲブルはスタンフォード大学のフェイフェイ・リの研究室に加わり、公開されている画像のデータマイニングを行った。彼女は、政府や非政府組織がコミュニティに関する情報を収集するために費やす金額に関心を持っていた。代替策を調査するため、ゲブルは深層学習とGoogle ストリートビューを組み合わせて、アメリカ合衆国の近隣地域の人口統計を推定した。これにより、投票パターン、収入、人種、教育などの社会経済的属性が、車の観察から推測できることを示した。例えば、ピックアップトラックの数がセダンの数を上回る地域では、共和党に投票する可能性が高いとされた。彼らはアメリカの人口上位200都市から1500万枚以上の画像を分析した。この研究はBBCニュース、『ニューズウィーク』、『エコノミスト』、『ニューヨーク・タイムズ』など、メディアで広く報じられた。

2015年、ゲブルはAI分野のトップ会議であるニューラル情報処理システムに関する会議(NIPS)にカナダのモントリオールで参加した。3,700人の参加者のうち、彼女は数少ない黒人研究者の一人であったと述べている。翌年再び参加した際には、8,500人の参加者のうち、黒人男性はわずか5人、黒人女性は彼女一人しかいないことに気づいた。この経験から、彼女は同僚のレディエット・アベベと共に、人工知能分野で活動する黒人研究者のコミュニティ「Black in AI」を設立した。Black in AIは、AI分野における黒人専門家やリーダーの存在感、可視性、福祉を向上させることで、AI分野へのアクセスを民主化することを目指している。

2017年夏、ゲブルはマイクロソフトに博士研究員として加わり、AIにおける公平性、説明責任、透明性、倫理(FATE)ラボで勤務した。同年、公平性と透明性に関する会議で講演し、『MITテクノロジーレビュー』のインタビューに応じた。このインタビューで彼女は、AIシステムに存在するバイアスと、AIチームに多様性を加えることでその問題をどのように解決できるかについて語った。ジャッキー・スノーからの「多様性の欠如は人工知能、特にコンピュータービジョンをどのように歪めるのか」という質問に対し、ゲブルはソフトウェア開発者にバイアスが存在することを指摘した。マイクロソフト在籍中に、ゲブルは共同研究論文「Gender Shades」を執筆した。これは、共同執筆者であるジョイ・ブオラムウィニが主導するマサチューセッツ工科大学のより広範なプロジェクトの名称にもなった。二人は顔認識ソフトウェアを調査し、ある特定のシステムでは黒人女性が白人男性よりも35%認識されにくいことを発見した。

2.2. GoogleでのAI倫理研究

2018年、ゲブルはGoogleに入社し、マーガレット・ミッチェルと共に人工知能の倫理に関するチームを共同で率いた。彼女は人工知能の持つ意味合いを研究し、テクノロジーが社会に良い影響を与える能力を向上させることを目指した。

2019年、ゲブルは他の人工知能研究者と共に、Amazonに対し、その顔認識技術を法執行機関に販売するのを中止するよう求める書簡に署名した。彼女らは、この技術が女性や有色人種に対してバイアスがかかっていることを理由に挙げ、Amazonの顔認識システムが他のテクノロジー企業の顔認識ソフトウェアよりも肌の色が濃い女性を識別するのに苦労していることを示すMITの研究を引用した。ゲブルは『ニューヨーク・タイムズ』紙のインタビューで、現時点では顔認識は法執行やセキュリティ目的で使用するには危険すぎるとの見解をさらに表明した。

2.3. 「確率的オウム」論文とGoogle退社

2020年、ゲブルは5人の共同執筆者と共に、「確率的オウムの危険性について:言語モデルは大きくなり過ぎる可能性があるのか?🦜」と題する論文を執筆した。この論文は、非常に大規模な言語モデル(LLM)のリスクを検証するもので、その環境フットプリント、経済的コスト、大規模モデルの不透明性、LLMが特定のグループに対して偏見を示す可能性、LLMが処理する言語を理解できないこと、そしてLLMが偽情報を拡散するために利用される可能性など、多岐にわたる問題点を指摘した。

2020年12月、Googleはゲブルに対し、論文を出版前に撤回するか、Googleに雇用されているすべての著者の名前を論文から削除するよう求めた後、彼女のGoogleでの雇用は終了した。6人の著者の中で、当時Googleに雇用されていなかったのはエミリー・M・ベンダーのみであった。ゲブルは、社内コラボレーションリストに送られた6ページのメールで、急な会議に呼び出され論文の撤回を求められた経緯を説明し、その決定を下したすべての関係者の名前と理由、およびGoogleの意向に沿って論文を修正する方法について情報を求めた。もしその情報が提供されない場合、彼女は「最終出社日」についてマネージャーと話し合うと述べた。Googleは彼女の要求に応じず、彼女の辞任を受け入れたと宣言し、直ちに雇用を終了した。ゲブルは、正式に辞任を申し出たわけではなく、辞任をちらつかせたに過ぎないと主張した。

GoogleのAI研究責任者であるジェフ・ディーンは、ゲブルの論文が、その中で述べられている問題の一部を軽減する方法に関する関連する最近の研究をあまりにも多く無視しているため、このような決定を下したと返答するメールを公開した。ディーンは、ゲブルの退社に関する自身の社内メールと、Googleの研究論文プロセスを「野心的な問題に取り組むが、責任を持って行う」と擁護する自身の考えを公開した。ゲブルらは、この最初の公開と、それに続くディーンの沈黙が、その後のハラスメントを助長し、可能にしたと非難している。ゲブルは、ソックパペットアカウントやインターネットトロールによってTwitter上で継続的に嫌がらせを受け、人種差別的で下品なコメントをされた。ゲブルとその支持者は、一部の嫌がらせが機械学習研究者のペドロ・ドミンゴスと実業家のマイケル・リサックによるものであり、彼らはゲブルの仕事を「科学を装った擁護活動」と呼んでいたと主張した。リサックはまた、ミッチェルやベンダー、そしてゲブルのかつてのチームの他の同僚にも嫌がらせをしたとされている。Twitterは2021年2月1日にリサックのアカウントアクセスを一時的に停止した。

ゲブルは繰り返し、自分が解雇されたと主張しており、2,700人近くのGoogle従業員と4,300人以上の学者および市民社会の支持者が、ゲブルの解雇とされる行為を非難する書簡に署名した。9人の連邦議会議員がGoogleに書簡を送り、ティムニット・ゲブルの退社状況を明確にするよう求めた。ゲブルのかつてのチームは、副社長のメーガン・カチョリアがチームの管理系統から外されることを要求した。カチョリアは、ゲブルの直属のマネージャーであるサミー・ベンジオに事前に通知することなくゲブルを解雇したとされており、ゲブルのかつてのチームは、カチョリアとディーンに対し、ゲブルへの対応について謝罪するよう要求した。ミッチェルは、GoogleがAIにおけるバイアスや有害性を排除しようと活動する従業員を扱った方法、特にゲブルの解雇とされる行為を批判するためにTwitterを利用した。ミッチェルはその後、機密性の高い業務関連文書や他の従業員の個人データを不正に持ち出したとして解雇された。

彼女の退社を巡る否定的な報道の後、Googleの親会社であるAlphabetの最高経営責任者(CEO)であるサンダー・ピチャイは、ゲブルが解雇されたのか辞任したのかを明確にしないままTwitterで公に謝罪し、この一件に関する数ヶ月にわたる調査を開始した。調査の結果、ディーンはGoogleが「特定の従業員が会社を去る際の対応方法」を変更すると発表したが、ゲブルのGoogle退社が自発的なものであったかどうかは依然として明確にしなかった。さらにディーンは、「機密性の高い」トピックを扱う研究論文の審査方法に変更があり、多様性、公平性、包摂性(DEI)の目標が四半期ごとにAlphabetの取締役に報告されると述べた。ゲブルはTwitterで、Googleからは「これ以上何も期待していなかった」と述べ、変更は彼女が解雇されたとされる要求によるものだが、誰もその責任を問われていないことを指摘した。この騒動の後、2人のGoogle従業員が会社を辞任した。

ゲブルの退社後、Googleは社内での人種差別に関する経験を議論するフォーラムを開催した。従業員はNBCニュースに対し、フォーラムの半分がゲブルの信用を傷つけることに費やされ、彼らはそれをGoogleが声を上げた彼女を見せしめにしていると受け取ったと報告した。このフォーラムの後、Googleの黒人従業員向けに、公認のセラピストによる集団心理療法セッションが開催されたが、従業員はゲブルの解雇とされる行為が引き起こした危害を軽視していると感じたという。

2.4. 分散型人工知能研究研究所(DAIR)の設立

2021年11月、ネイサン・カミングス財団はOpen MICと提携し、Color of Changeの支持を得て、Alphabetの「黒人、先住民、有色人種(BIPOC)コミュニティ」に対する「悪影響」を分析するための「人種的公平性監査」を求める株主提案を提出した。この提案はまた、Googleが差別に関する懸念を表明した少数派の従業員に対して報復を行ったかどうかを調査するよう求めており、ゲブルの解雇、Googleがより多くのBIPOCを雇用するよう求めた彼女の以前の要請、そしてGoogleのテクノロジーにおける人種に基づくバイアスに関する彼女の研究を引用している。この提案は、同年初めにコリー・ブッカーが主導した上院民主党議員団による非公式な要請に続くものであり、これもゲブルの退社と彼女の仕事を引用していた。

2021年12月、『ロイター』は、Googleがカリフォルニア州公正雇用住宅局(DFEH)から黒人女性の待遇について調査を受けていると報じた。これは、現職および元従業員による多数の差別およびハラスメントの正式な苦情を受けたものである。この調査は、ゲブルや他のBIPOC従業員が、人事部に人種差別や性差別に関する経験を報告した際、会社の従業員支援プログラム(EAP)を通じて病気休暇やセラピーを受けるよう勧められたと報告した後に開始された。ゲブルらは、彼女の解雇とされる行為は報復であり、Googleが制度的に人種差別的である証拠であると考えている。Googleは、「この重要な仕事に引き続き注力し、あらゆる懸念を徹底的に調査し、Googleが代表的で公平であることを確認する」と述べた。

2021年6月、ゲブルは「Googleの倫理的AIチームでの自身の仕事と、Black in AIでの経験をモデルにした独立研究機関を立ち上げる」ための資金を調達していると発表した。

2021年12月2日、彼女は分散型人工知能研究研究所(DAIR)を設立した。この研究所は、AIが周縁化されたグループに与える影響を文書化することを目的としており、特にアフリカおよびアメリカ合衆国のアフリカ系移民に焦点を当てている。DAIRの初期プロジェクトの一つは、南アフリカ共和国のタウンシップの衛星画像をAIで分析し、アパルトヘイトの遺産をより深く理解することを目指している。

3. 主な研究分野と貢献

ティムニット・ゲブルは、AIシステムにおける公平性と社会的影響に焦点を当て、その分野で重要な貢献を果たした。

3.1. アルゴリズムバイアスと公平性

ゲブルは、AIシステム内に存在するバイアスを特定し、それを緩和するための研究および方法論に深く貢献した。彼女の研究は、特に顔認識システムにおける性別および人種間の精度格差を明らかにした「Gender Shades」プロジェクトに代表される。彼女は、AI開発チームの多様性の欠如が、AIシステムのバイアスを歪める原因であると指摘し、多様な視点を取り入れることの重要性を強調している。

3.2. 顔認識技術とジェンダー/人種間の格差

ゲブルはジョイ・ブオラムウィニと共に「Gender Shades」プロジェクトを立ち上げ、商用顔認識システムの性別および人種間における精度格差を明らかにした。この研究では、ある特定のシステムにおいて、黒人女性が白人男性よりも35%認識されにくいという結果が示された。彼女は、この研究結果を引用し、Amazonなどの企業に対し、顔認識技術を法執行機関へ販売することの中止を求める書簡に署名した。彼女は、現時点では顔認識技術は法執行や安全保障の目的で使用するには危険すぎるという見解を表明している。

3.3. 大規模言語モデル(LLM)のリスク

ゲブルは、2020年に発表された「確率的オウムの危険性について:言語モデルは大きくなり過ぎる可能性があるのか?🦜」という論文の共同執筆者である。この論文は、大規模言語モデル(LLM)が持つ潜在的なリスクを包括的に分析した。具体的には、LLMの環境コスト、運用にかかる莫大な財政的コスト、その内部動作の不透明性(ブラックボックス化)、特定のグループに対する偏見や差別を助長する可能性、LLMが学習した言語の根底にある概念を真に理解できないという限界、そして偽情報や誤情報の拡散に悪用される可能性などが指摘された。

3.4. AI倫理と社会的影響

ゲブルの研究は、AI技術が社会全体、特に疎外された集団に及ぼす倫理的・社会的な影響を探求し、改善策を提示することに重点を置いている。彼女は、AIシステムが社会に良い影響を与える能力を向上させることを目指し、AI開発における多様性と包摂性の重要性を強調している。彼女はまた、テクノロジー分野における「ボーイズクラブ文化」を批判し、会議での性的嫌がらせや分野の著名人に対する英雄視といった問題にも言及している。

4. 社会運動と擁護活動

ティムニット・ゲブルは、AI分野の多様性促進と社会正義の実現に向けた積極的な取り組みで知られている。

4.1. Black in AIの共同設立と活動

ゲブルはレディエット・アベベと共に「Black in AI」を共同設立した。これは、人工知能分野で活動する黒人研究者のコミュニティであり、AI分野における黒人専門家やリーダーの存在感、可視性、福祉を向上させることで、AI分野へのアクセスを民主化することを目指している。Black in AIは、2017年から毎年ニューラル情報処理システムに関する会議(NIPS)でワークショップを開催している。

4.2. テクノロジー分野における多様性と包摂性の促進

ゲブルは、STEM分野、特にAI研究において女性およびマイノリティの参加を拡大するための擁護活動に尽力している。彼女は、2016年に参加したAI会議で、8,500人の参加者の中で黒人男性がわずか5人、黒人女性は彼女一人しかいなかったという経験から、AI分野における多様性の欠如を強く認識した。彼女は、AIシステムにおけるバイアスは、ソフトウェア開発者自身のバイアスに起因すると指摘し、多様なチームがAIシステムに存在するバイアスを修正できると主張している。

4.3. TESCREAL批判とテクノロジー倫理への批判

ゲブルはエミール・P・トーレスと共に、トランスヒューマニズム、エクストロピー主義、シンギュラリティ論、ロシア宇宙主義、合理主義、効果的利他主義、長期主義といった、重なり合う未来主義哲学のグループを批判するために「TESCREAL」という新語を造語した。ゲブルはこれらを巨大テクノロジー企業における右翼的な影響と見なし、その提唱者たちを「人類に利益をもたらす」と称しながら有害なプロジェクトを生み出す「20世紀の優生学者」と比較している。ゲブルは、汎用人工知能(AGI)の研究が優生学に根ざしていると批判しており、AGIの構築を試みることは本質的に安全でない行為であるため、AGIから焦点を移すべきだと主張している。

5. 受賞と表彰

ティムニット・ゲブルは、その学術的および社会的な貢献が認められ、数々の賞を受賞している。

- 2019年:ジョイ・ブオラムウィニ、イニオルワ・デボラ・ラジと共に、顔認識におけるアルゴリズムバイアスの重大な問題を浮き彫りにした研究により、『ベンチャービート』の「AI for Good」部門でAIイノベーション賞を受賞した。

- 2021年:『フォーチュン』誌の「世界の最も偉大なリーダー50人」の一人に選ばれた。科学雑誌『ネイチャー』が選ぶ「2021年に科学を形成した10人」にも選出された。

- 2022年:『タイム』誌の「2022年において最も影響力のある100人」の一人に選ばれた。

- 2023年:カーネギー・コーポレーション・オブ・ニューヨークにより「偉大な移民賞」の受賞者に選ばれた。これは、彼女の倫理的AI分野への多大な貢献が評価されたものである。同年11月には、BBCの「100人の女性」リストに、世界を鼓舞し影響力のある女性の一人として選ばれた。

6. 影響力と遺産

ティムニット・ゲブルは、人工知能の倫理に関する議論、テクノロジー産業の実践、そしてSTEM分野における疎外された集団に多大な影響を与えてきた。彼女の「Gender Shades」プロジェクトは、顔認識システムにおけるアルゴリズムバイアス、特にジェンダーと人種間の精度格差を明確に示し、AIの公平性に関する意識を世界的に高めた。この研究は、AI技術の設計と展開における倫理的考慮の必要性を強調し、企業や政策立案者に対し、より公平で包摂的なAIシステムの開発を促すきっかけとなった。

Google退社を巡る騒動は、巨大テクノロジー企業における企業の説明責任、言論の自由、そして多様性と包摂性の欠如といった問題に光を当てた。彼女の主張は、多くのGoogle従業員や学術界、市民社会の支持を得て、企業文化や研究の独立性に関する広範な議論を巻き起こした。この出来事は、AI倫理研究者が直面する課題を浮き彫りにし、研究の独立性を守るための新たな枠組みの必要性を訴えるものとなった。

彼女が設立した分散型人工知能研究研究所(DAIR)は、周縁化されたコミュニティ、特にアフリカおよびアメリカ合衆国のアフリカ系移民に対するAIの影響を文書化することに焦点を当てており、グローバルサウスにおけるAI研究の重要性を高めている。また、Black in AIの共同設立者として、彼女はAI分野における黒人研究者の可視性と福祉を向上させ、より多様で包摂的なAIコミュニティの構築に貢献している。

TESCREAL批判を通じて、ゲブルはトランスヒューマニズムや効果的利他主義といった特定のテクノロジー哲学が持つ潜在的な危険性、特に優生学的な思想との関連性を指摘し、汎用人工知能(AGI)の追求が本質的に安全ではないという警鐘を鳴らしている。彼女の活動は、AIの未来に対する批判的な視点を提供し、テクノロジーが社会に与える影響について、より深く、倫理的な考察を促す遺産を残している。

7. 主要な出版物

- Gebru, Timnit. 『Visual computational sociology: computer vision methods and challenges』. スタンフォード大学博士論文, 2017年8月1日.

- Gebru, Timnit; Krause, Jonathan; Wang, Yilun; Chen, Duyun; Deng, Jia; Aiden, Erez Lieberman; Fei-Fei, Li. 「Using deep learning and Google Street View to estimate the demographic makeup of neighborhoods across the United States」. 『Proceedings of the National Academy of Sciences』, Vol. 114, No. 50, 2017年12月12日, pp. 13108-13113.

- Buolamwini, Joy; Gebru, Timnit. 「Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification」. 『Proceedings of Machine Learning Research』, Vol. 81, 2018年, pp. 1-15.

- Gebru, Timnit. 「Race and Gender」. 『The Oxford Handbook of Ethics of AI』, オックスフォード大学出版局, 2020年7月9日, pp. 251-269.

- Gebru, Timnit; Torres, Émile P. 「The TESCREAL bundle: Eugenics and the promise of utopia through artificial general intelligence」. 『First Monday』, Vol. 29, No. 4, 2024年4月1日.

8. 関連項目

- Coded Bias

- クレア・ステープルトン

- メレディス・ホイッタカー

- ソフィー・チャン (内部告発者)